|

Поисковая система Google предоставляет удобный и многофункциональный сервис для анализа интернет-сайтов: Google Webmaster Tools*. Благодаря целому ряду инструментов вы сможете отслеживать появление страниц своего сайта в индексе поисковой машины, наличие ссылок на свои страницы с других ресурсов, анализировать ошибки доступа к страницам, с которыми столкнулся робот поисковой машины при индексации вашего сайта, тестировать директивы robots.txt для доступа к сайту различных роботов, управлять скоростью доступа роботов к сайту и многое другое.

Для работы с инструментами веб-мастера вам понадобится создать учетную записьВ первую очередь для работы с инструментами веб-мастера вам понадобится учетная запись на Google. Для того чтобы зарегистрировать новый аккаунт, требуется заполнить форму на странице создания новой учетной записи. Здесь вы должны будете указать адрес электронной почты, выбрать пароль для своей учетной записи, указать, из какой вы страны, и выразить согласие с правилами использования сервисов.

Далее вам на указанный адрес электронной почты придет письмо для подтверждения регистрации. Просто перейдите по ссылке в письме – и ваша учетная запись будет активна и готова к использованию. Теперь для входа в свой аккаунт вы можете использовать форму тут: https://www.google.com/accounts/Login.

Далее вам понадобится активировать инструменты для веб-мастера (Google webmaster tools) для вашей учетной записи. В последствии закладка Webmaster Tools появится в списке доступных сервисов вашей учетной записи.

|

| Начало работы с Google Webmaster Tools |

Для этого зайдите на страницу начала работы с Google Webmaster Tools. Уже на следующем шаге работы с сервисом вы сможете добавить свой сайт через форму.

Сразу же после добавления вы сможете получить сводную информацию, которой располагает Google о вашем ресурсе: какие страницы проиндексированы, когда в последний раз поисковый робот посещал сайт, страницы каких сайтов содержат ссылку на ваш, анализ robots.txt вашего сайта.

Пройдя процедуру подтверждения принадлежности сайта, вы получите полный доступ ко всем инструментамНо чтобы получить доступ к более расширенной и полезной информации, вам необходимо доказать, что вы имеете отношение к данному сайту. Есть два способа верификации сайта: посредством добавления специального метатега или загрузкой специального html-файла на сервер.

В первом случае вы получите метатег вида <meta name="verify-v1" content="DJZA+3eKAvAfOooWOGPKxTHnDtKHnHJkMaCMlwSoye8=" />, который необходимо будет вставить в раздел заголовков <head></head> вашей страницы.

Во втором случае вам будет сообщено название html-файла, который вам необходимо будет создать и загрузить в корневую директорию сайта. После того как вы убедитесь, что файл доступен на сервере, вы должны будете отправить ваш сайт на проверку. После того как тег будет установлен или файл создан, их наличие проверено, вы получите полный доступ к статистике вашего сайта.

|

| Диагностика ошибок индексации сайта |

В первую очередь — это информация об ошибках, происходивших во время индексации сайта. На вкладке Diagnostic — Summary в разделе Web Crawl Errors перечислены ошибки HTTP доступа к сайту, недоступные для поискового робота страницы, ненайденые страницы, страницы, недоступные по тайм-ауту. Поисковый робот мог попасть на эти страницы из карты сайта или по ссылкам с других сайтов. Вы сможете получить подробный отчет о том, какие страницы были недоступны, когда доступ был невозможен, и сможете проверить, устранена ли эта ошибка сейчас.

В разделе Diagnostic — Crawl Errors – Mobile Web вы получите статистику ошибок индексирования мобильного сайта.

|

| Анализ файла robots.txt |

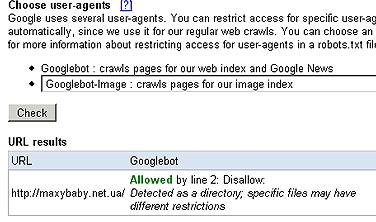

Раздел robots.txt analysis (анализ файла robots.txt) на вкладке Diagnostic — Tools (инструменты) сообщает о том, когда в последний раз был считан robots.txt для вашего сайта, был ли доступ удачным, все ли директивы, перечисленные в этом файле, были понятны поисковому роботу. Вы увидите текст вашего robots.txt в том виде, в котором он был загружен с сервера в последний раз. Если с тех пор в файл были внесены какие-то изменения, вы можете испробовать их прямо тут: просто сделайте необходимые изменения в тексте, перечислите адреса страниц, доступность которых для поискового робота в соответствии с данным robots.txt вы хотите проверить, и выберите, для какого именно робота следует провести анализ. Вам на выбор будут предоставлены такие кроулеры: Googlebot-Mobile (робот, собирающий информацию о мобильных сайтах), Googlebot-Image (робот, индексирующий картинки на сайте), Mediapartners-Google (робот, собирающий информацию о сайте для размещения объявлений AdSense). Запустив проверку, вы узнаете, доступны ли указанные страницы вашего сайта для этих роботов, и если нет, то какая именно строка в robots.txt запрещает индексацию этой страницы.

Вы можете снизить нагрузку от поисковых роботов на сервер, снизив скорость сканирования страницВ разделе Diagnostic – Tools – Crawl Rate вы можете выбрать скорость, с которой Googlebot будет просматривать ваши страницы. По умолчанию скорость установлена на среднем значении (Normal — recommended crawl rate). В случае если вы можете позволить, чтобы нагрузка от робота на ваш сервер увеличилась, укажите более быстрый уровень просмотра сайта (Faster), если же вы хотите снизить нагрузку на сервер и при этом согласны, что индексация страниц будет происходить медленнее, выберите опцию Slower.

Также в этом разделе вы узнаете, сколько в среднем страниц вашего сайта индексируется за день, сколько килобайт информации анализируется, сколько времени тратит робот на просмотр одной страницы. Эта статистика основана на данных за последние 90 дней. Раздел Diagnostic – Tools – Preferred Domain позволит вам выбрать, какой именно домен должен быть отображен в результатах поиска. Например, вы предпочитаете использовать имя сайта www.site.com вместо site.com. Для того, чтобы в результатах поиска адрес вашего сайта выдавался как www.site.com, и нужно задать предпочтительный домен в этом разделе инструментов веб-мастера. Чтобы эти изменения вступили в силу и были отображены в индексе поисковой машины, потребуется какое-то время.

Diagnostic – Tools – Enhanced Image Search позволит вам разрешить поиск по картинкам, содержащимся на вашем сайте. В случае если эта опция включена, Google будет использовать технологию Google Image Labeler*, для того чтобы ассоциировать картинки, имеющиеся на вашем сайте, со специальными метками, что позволит лучше индексировать и впоследствии находить эти изображения по соответствующим им запросам. Там же вы в случае необходимости можете запретить поиск по картинкам.

|

| Заявка на удаление страниц из индекса |

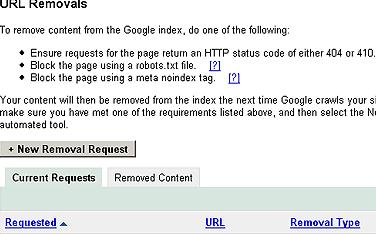

И, наконец, удалить страницы из индекса Google вам поможет раздел Diagnostic – Tools – Url Removals. Но, для того чтобы страница была удалена, она должна соответствовать следующим параметрам: либо запрос к удаляемой странице должен возвращать код статуса HTTP 404 (страница не найдена) или 410 (страница удалена), либо индексация этой страницы должна быть запрещена соответствующей директивой файла robots.txt, либо в мета-тегах страницы должен быть указан запрет к индексации noindex. Убедившись, что страница, которую вы хотите удалить, соответствут этим требованиям, вы нажимаете на кнопку New Removal Request, выбираете, что именно вы хотите удалить: одиночные страницы, директорию на сайте, весь сайт или кешированную копию и описание страницы из результата поиска.

Процедура удаления страниц из индекса по запросу занимает некоторое времяЕсли вы удаляете отдельные страницы вашего сайта, далее вам будет предложено ввести адреса удаляемых страниц и указать, из какого именно индекса поисковой машины вы хотите их удалить: из результатов обычного поиска или поиска изображений. Максимальное количество запросов на удаление – 100.

Если вы удаляете из поиска директорию сайта, вам необходимо будет указать абсолютный путь к этой директории, таким образом, будет отправлен запрос на удаление из индекса всех файлов и директорий, содержащихся в ней.

Если вы выберете удаление всего сайта, вам придется еще раз подтвердить, что вы хотите удалить его.

При удалении кешированной копии страницы вам нужно будет указать адрес страницы и объяснить причину подачи этой заявки: либо на страницу был добавлен мета-тег noarchive, запрещающий кеширование результата поиска по странице, либо же страница была модифицирована и более не содержит информации, содержащейся в кеше.

Заявки на удаление контента выполняются не мгновенно. Какое-то время запросы будут отображены в таблице Current Requests, и вы сможете видеть статус заявки на текущий момент. В удалении некоторых страниц может быть отказано, например, если удаляемая страница по-прежнему существует и не запрещена к индексации мета-тегами или директивой файла robots.txt. Историю обработанных запросов вы можете просмотреть в таблице Removed Content.

Таким образом, в данной статье были рассмотрены процедура регистрации и подключения инструментов веб-мастера Google Webmaster Tools к учетной записи пользователя Google, авторизация сайта в системе и инструменты для диагностики сайта.

Ссылки по теме

- Регистрация учетной записи Google

- Вход в учетную запись Google

- Начало работы с Google Webmaster Tools

Статья получена: hostinfo.ru

Противовирусные препараты: за и против

Противовирусные препараты: за и против Добро пожаловать в Армению. Знакомство с Арменией

Добро пожаловать в Армению. Знакомство с Арменией Крыша из сэндвич панелей для индивидуального строительства

Крыша из сэндвич панелей для индивидуального строительства Возможно ли отменить договор купли-продажи квартиры, если он был уже подписан

Возможно ли отменить договор купли-продажи квартиры, если он был уже подписан Как выбрать блеск для губ

Как выбрать блеск для губ Чего боятся мужчины

Чего боятся мужчины Как побороть страх перед неизвестностью

Как побороть страх перед неизвестностью Газон на участке своими руками

Газон на участке своими руками Как правильно стирать шторы

Как правильно стирать шторы Как просто бросить курить

Как просто бросить курить

- 3772 -

- 3772 -